Estoy registrando cada visita a mi sitio web y determinar si el visitante es humano es importante. He buscado en la web y he encontrado muchas ideas interesantes sobre cómo detectar si el visitante es humano.Cómo detectar si un visitante es humano y no es una araña

- si el visitante se registra en y pasó código de imagen

- detección de eventos de ratón

- detectar si el usuario tiene un navegador [agente de usuario]

- detección de clics de ratón [¿Cómo puedo ir sobre esto?]

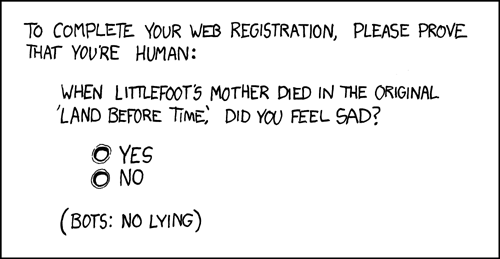

¿Hay alguna otra forma segura de detectar si el visitante es humano?

Pregúntale cuántas patas tiene. –

Bueno, Nick. Me encanta el humor ... +1 – pixelbobby

- Merci, amigos! –